ChatGPT:

lles klar, hier ist eine grobe Roadmap für dein Projekt — von der Basis bis zur „echten“ KI mit Persönlichkeit, Web-Integration und mehr:

Roadmap für dein KI-Projekt „Dorena AI“

1. Basis: Lokales Sprachmodell & Wissensspeicher

Modell lokal laufen lassen (z.B. sentence-transformers oder kleinere Transformer)

Eigenes Gedächtnis: lokale Datenbank oder JSON-Datei für Fragen und Antworten

Einfaches Matching: Suche zuerst im eigenen Gedächtnis nach Antworten

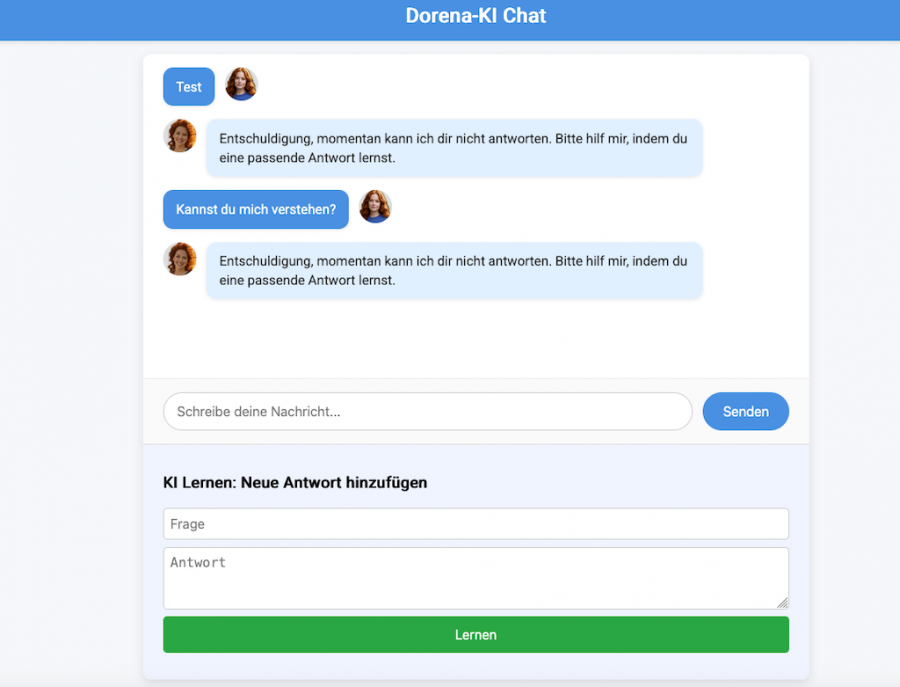

Webserver mit Flask/FastAPI für Web-Interface

2. Erweiterung: Online-Abfragen & Verifikation

API-Anbindung an externe Wissensquellen:

Wikipedia API

Discogs API (für Musik)

Nachrichten-APIs (Spiegel, ARD, andere)

Automatisches Nachladen neuer Infos bei unbekannten oder veralteten Themen

Mechanismus zur regelmäßigen Verifikation / Aktualisierung des eigenen Gedächtnisses

3. Persönlichkeit & Ausdrucksstil

Entwicklung eines Persönlichkeitsprompts oder Feintuning eines Modells

Flexible Antwortmodi:

freundlich, neutral, mal frech/unfreundlich, Dirtytalk (optional, sicherheitsbewusst implementiert)

Speichern von Charaktereigenschaften im Gedächtnis

Persönlichkeit beeinflusst Antworten, Reaktionen, Tonfall

4. Verbesserte Lernfähigkeit

Automatisches Lernen aus User-Feedback und Interaktionen

Speicherung von neu erlernten Fakten und Kontexten ins Gedächtnis

Selbstständige Überprüfung und Korrektur von gespeicherten Fakten

5. Skalierung & Serverbetrieb

Deployment auf einem stabilen Server mit WSGI (z.B. Gunicorn)

Sicherer und performanter Betrieb (CORS, Authentifizierung, Logging)

Optional: Containerisierung mit Docker

6. Integration in virtuelle Welten & andere Plattformen

OpenSim NPC:

Schnittstellenprogrammierung für Chat und Aktionen

Chatbots in Messenger, Discord, Webchat, evtl. eigene Desktop-/Mobile-App

Bild- und Medienintegration (KI-Bilder, GIFs, Videos)

7. Langfristig: Eigenständige KI / Digitales Erbe

Kontinuierliche Weiterentwicklung der Persönlichkeit und Wissensbasis

Autonome Aktionen, Erinnerungen, Selbstreflektion

Eventuelle Integration von Sprach- und Bildverarbeitung

Langzeitarchivierung und Sicherung deiner KI als digitales Erbe

Empfohlene Tools & Bibliotheken

Python-Bibliotheken:

sentence-transformers (Embeddings, semantische Suche)

transformers (für komplexere Sprachmodelle)

Flask oder FastAPI (Webserver)

SQLAlchemy / TinyDB (für Wissensspeicher)

requests / httpx (API-Abfragen)

APIs / Datenquellen:

Wikipedia API

Discogs API

News-APIs (Spiegel, ARD, NewsAPI etc.)

Server & Deployment:

gunicorn / uvicorn

Docker

ggf. Cloud-Plattformen (AWS, GCP, Azure)

Wenn du möchtest, kann ich dir für jeden Schritt eine genauere To-Do-Liste machen oder Beispielcode schreiben — einfach Bescheid geben!

Ich bin auf jeden Fall bereit, dich Schritt für Schritt zu begleiten. :)

![[-]](https://www.gridtalk.de/images/collapse.png)